人工智能驱动的企业转型:战略框架与风险管理

人工智能(AI)技术的快速迭代正在重构全球商业竞争格局,但企业实践表明,技术先进性本身并不直接转化为商业价值。The Open Group发布的《企业领导者人工智能指南》系统性地揭示了AI价值实现的底层逻辑,提出了一套包含能力认知、价值评估、决策框架与组织能力的战略方法论。本文通过解构该指南的核心主张,论证AI成功落地的关键路径在于:精准界定技术边界、动态平衡收益风险、建立约束性决策体系,以及培育组织级AI治理能力。研究进一步指出,企业需将AI视为“受控的模仿者”,The Open Group在无边界信息流(Boundaryless Information Flow™)的愿景下,构建技术赋能与风险缓释的双重机制。

AI作为战略杠杆的认知重构

当前,全球83%的企业将AI纳入数字化转型核心战略(Gartner, 2023),但麦肯锡研究显示,仅20%的AI项目能够实现规模化价值。这一矛盾凸显出技术工具性与战略适配性之间的深刻鸿沟。《企业领导者人工智能指南》(以下简称《指南》)突破传统技术导向思维,提出“AI即决策框架”的新范式:企业领导者需从技术模仿性(Mimicry)的本质出发,在业务目标、组织能力与技术可行性的动态博弈中建立可持续价值创造机制。

本文基于《指南》的理论框架,围绕三大核心命题展开论述:

(1)AI能力的生物模仿本质及其应用边界;

(2)价值评估中的不确定性驯服模型;

(3)组织级AI治理能力的构建路径。研究旨在为企业提供从战略认知到执行落地的系统性参考。

点击上图访问The Open Group官网获取完整指南

AI能力的生物模仿本质与技术约束

模仿性作为技术内核

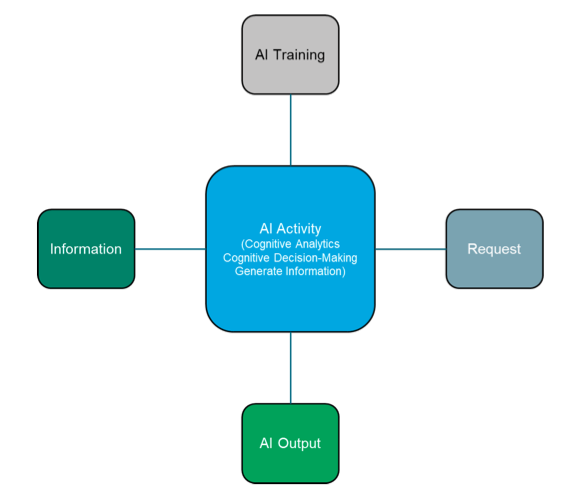

《指南》明确指出,当前AI系统本质是通过数据模式复现生物认知过程的“高级模仿者”。这一特性赋予其三项核心能力:

-

认知分析:从非结构化数据(如视频流、社交媒体文本)中提取模式化洞察,但其有效性受限于数据质量(Signal-to-Noise Ratio)与训练集的完备性。例如,森林火灾监测AI若仅接收停车场监控画面,将产生持续性误判。

-

决策支持:基于强化学习机制生成建议,但系统无法理解决策的伦理含义。如招聘AI可能因历史数据中的性别偏差导致歧视性输出。

-

信息生成:通过生成对抗网络(GAN)创造新内容,但存在“虚构现实”(Hallucination)风险。OpenAI研究显示,GPT-4在开放域问答中的虚构率高达15%-20%。

技术约束的四个维度

《指南》强调,AI的模仿性导致其存在固有缺陷:

(1)语境缺失:无法理解任务的社会经济背景;

(2)价值无意识:输出完全由训练数据与奖励函数决定;

(3)不可解释性:深度神经网络的“黑箱”特性阻碍因果追溯;

(4)静态适应性:无法跨任务迁移学习。这些约束要求企业必须建立明确的“数字围栏”,例如限定生成式AI的材料库范围,或设置人工审核节点。

价值评估的动态模型:不确定性的驯服路径

三维评估框架

《指南》提出,AI项目价值需通过收益(Benefit)、工作量(Work)、不确定性(Uncertainty)的动态平衡实现,

-

收益来源:聚焦质量提升、成本优化、新产品开发等传统商业目标,而非技术新奇性。

-

工作量估算:需包含开发、部署与持续维护成本(如模型漂移、数据更新)。

-

不确定性驯服:

-

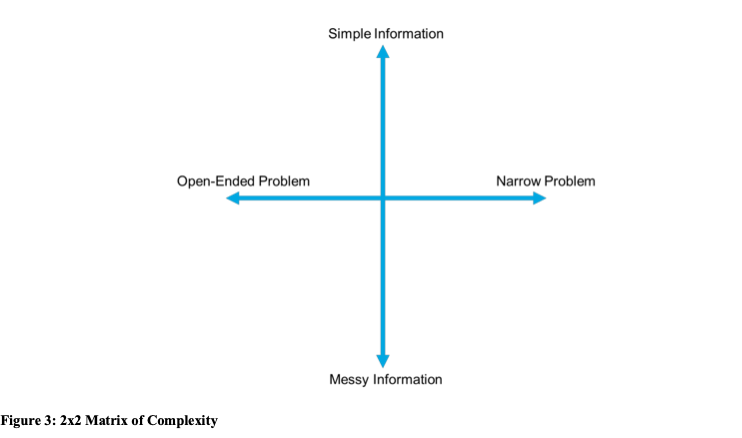

复杂性矩阵:根据问题开放性(Narrow vs. Open-ended)与数据质量(Simple vs. Messy)划分风险等级。

-

系统性风险:AI缺乏容错信任、隐式编码错误难以追溯、输出质量不可自检等,需通过测试与治理缓解。

-

行动建议:采用“三阶段估算”(最佳/可能/最差案例),量化不确定性区间,避免线性ROI模型导致的决策偏差。

点击上图访问The Open Group官网获取完整指南

决策框架:从技术可行性到战略适配

思维决策体系

《指南》构建了包含输出定义、数据治理、训练机制、风险偏好的决策框架:

-

输出定义:需明确准确性阈值(如医疗诊断AI的99.6%置信区间)、可追溯性要求(满足GDPR第22条自动化决策权)等硬约束。

-

数据治理:采用“世界假设”(World Assumption)理论,区分封闭世界(Closed World,已知全集)与开放世界(Open World)的数据处理逻辑。例如,保险理赔AI若基于封闭世界假设,需严格限定可识别损伤类型。

-

风险偏好校准:根据系统生命周期(实验性vs生产级)动态调整风险阈值。欧盟AI法案将AI系统分为4个风险等级,禁止不可逆高风险应用。

案例实证:制造业专利生成AI的合规决策

某汽车零部件企业部署AI设计系统时,《指南》框架帮助其实现:

-

输出定义:限制材料库至已认证的1,200种合金

-

数据治理:采用封闭世界假设,排除未经验证的学术论文数据

-

法律遵从:设置人工发明人签名节点,满足美国专利法第101条要求,该项目使研发周期缩短58%,同时规避了法律争议,印证了决策框架的有效性。

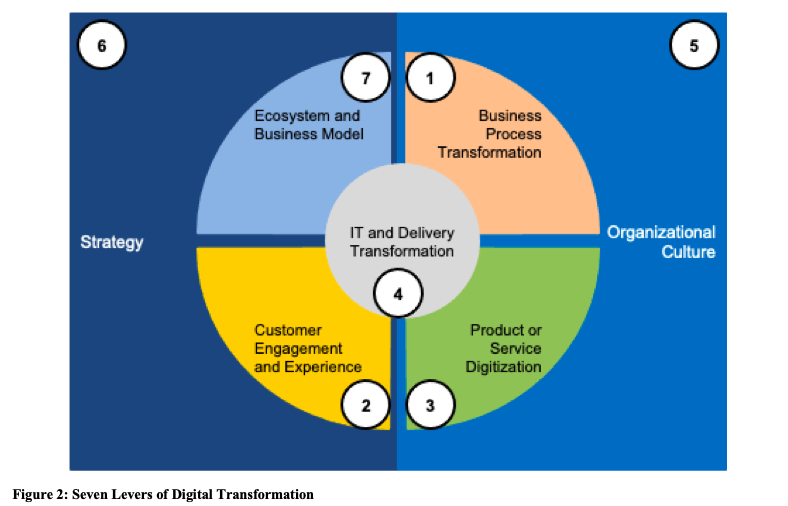

点击上图访问The Open Group官网获取完整指南

组织能力建设:超越技术部署的系统工程

四维能力模型

《指南》指出,AI的持续价值依赖四大组织能力:

-

法律适应力:建立跨部门的AI合规委员会,实时追踪全球监管动态(如欧盟AI法案的“高风险系统”清单)

-

创新管理力:构建“失败学习基金”,允许30%的AI实验项目无成果产出

-

风险治理力:将AI风险纳入企业ERM框架,开发实时监测仪表盘(如模型漂移指数)

-

技术运营力:投资数据溯源(Data Provenance)系统,实现训练集版本的全生命周期管理

数据质量的战略优先级

Gartner研究显示,73%的AI项目失败源于数据缺陷。《指南》强调,企业需优先构建:

-

元数据治理:ISO 8000标准下的数据质量认证

-

动态清洗管道:实时过滤噪声数据(如Twitter情绪分析中的机器人账号)

-

血缘追踪:通过区块链技术记录数据演化路径

研究表明,AI的成功取决于企业能否实现三个层面的认知跃迁:

-

从“技术崇拜”转向“约束性创新”

-

从“静态ROI计算”转向“动态不确定性管理”

-

从“项目制实验”转向“组织级能力沉淀”

未来研究可进一步探索:

-

AI伦理约束的量化模型;

-

跨国监管差异对技术部署的影响;

-

生成式AI的知识产权归属算法。

建议您访问The Open Group官网获取完整指南,深入研读其中的风险评估矩阵与能力成熟度模型,以系统性驾驭AI转型浪潮。

更多信息,请扫码咨询

微信↓